Qué es el vishing, la nueva estafa potenciada por inteligencia artificial que asedia a WhatsApp

Ya no se puede -ni se debe- confiar en nadie. Esa es, por lejos, la enseñanza clave que puede ofrecer esta nota. Al menos, relacionada con las estafas vía WhatsApp.

Al principio, las estafas eran por chat: alguien que nos hablaba desde la cuenta de un contacto, se hacía pasar por él, y usualmente pedía dinero para salir de un apuro. O por mail, conocidas como phishing: un correo electrónico que dice ser de un banco o una tarjeta de crédito, y nos alerta de un problema que hay con nuestros ahorros. Pasó por estos días en La Pampa, donde robaron más de 60 millones de pesos con un sitio web trucho; verificar que el sitio del home banking es el correcto es, en este caso, vital.

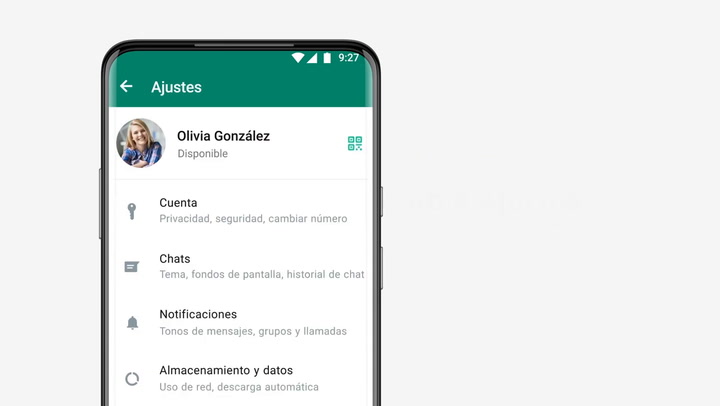

Esta estrategia para aprovecharse de las víctimas sigue en pie, pero el texto es complementado por llamadas de alguien que dice ser del banco, del Ministerio de Salud, de una encuestadora, de una promotora: da igual, y lo que aduce es que nos enviará un código para validar la línea; lo que intenta es apoderarse de ella, y de los contactos asociados para hacerse pasar por nosotros en otro chat. Cómo evitarlo: activando el doble factor de autenticación de WhatsApp, que es muy fácil de hacer y agrega una clave secreta.

A esto hay que sumarle, hace unos años, el vishing: como el phishing, pero con la voz. Es decir, hacerse pasar por otra persona, pero en vez de chatear, hablando por teléfono. ¿Por qué? Porque como humanos le asignamos un valor enorme a la voz; somos capaces de detectar el estado de ánimo de alguien en cuanto dice dos palabras, de reconocer cómo habla aunque haya ruido, etc. Así que si quien habla parece ser un familiar o amigo, vamos a tender a creerle. Si encima se escuda en que se escucha porque está en un lugar con mala señal -verosímil- es más fácil caer en la trampa. Ya hay varios casos conocidos de estafas aplicadas así en el mundo.

Ahora se suma una vuelta de tuerca a esto, de la que se está hablando mucho, aunque no haya demasiadas pruebas de su puesta en práctica (por suerte): del vishing potenciado por inteligencia artificial. ¿Qué es esto? La estafa por voz, pero aprovechando que hay herramientas que pueden clonar una voz a partir de unas pocas frases, y tienen la ductilidad de los chatbots modernos para generar un diálogo fluido si la víctima se escapa del guión. Es decir: ahora se puede programar un chatbot para que insista, haga chistes para alivianar la charla, meta la referencia a algún dato compartido si lo obtuvo; cosas que una persona mencionaría, que hacen que la estafa sea más creíble; que la persona falsa montada del otro lado de la llamada se comporte como una real.

¿Es posible? Sin duda: la última versión de GPT-4o tiene unos modelos de generación de voces que parecen personas, y una capacidad para charlar entonando la voz que confundirían a cualquiera. Del otro lado, Google promete un asistente digital que monitorea una llamada de teléfono -pero no de WhatsApp, que está cifrada- y nos avisa si nos están pidiendo datos sospechosos.

¿Hay algo para hacer, frente a una tecnología que es cada vez más sofisticada a la hora de simular a otra persona? Porque podríamos pedirle una prueba gráfica (sacate una foto haciendo una postura particular), pero en la era del deepfake (que permite agregarle cualquier rostro a cualquier cuerpo de una manera medianamente convincente) no es una prueba tan confiable.

Lo primero es usar el sentido común: si nos escribe alguien con quien no tenemos un trato fluido, para pedirnos dinero (por poco que sea) y no es algo que sucede habitualmente, hay razón para sospechar. Le podemos pedir hacer una llamada (que tratará de evitar, diciendo que está en un lugar donde no se puede hablar) para hablar con esa persona y hacerle preguntas que no están anotadas en ningún lado (de qué charlamos ayer, qué comimos aquella vez en lo un amigo, qué opino sobre tal tema, etcétera) para verificar su identidad; podemos probar con una videollamada (todavía el deepfake en vivo no es tan bueno, y menos para “enchufar” a WhatsApp); podemos pedirle una foto o descripción de algún rasgo que sabemos que la otra persona tiene (un tatuaje, una cicatriz), que son difíciles de clonar, ya que estos sistemas de clonación hacen foco en el rostro.

Pero sobre todo hay que desconfiar siempre, y no apresurarse: el apuro del otro por recibir dinero no puede ser nuestro, por muy desesperante que sea la situación que nos pintan. Más si nos dice que hagamos la transferencia a nombre de un tercero. Y es fundamental lograr hablar con esa persona que está en apuros: sea presencial, o a través de un tercero que pueda demostrarnos que quien necesita dinero es la persona real y no un estafador. Si nos llama alguien que dice ser de un banco, un ministerio, organismo público, etcétera, antes de brindar algún dato hay que ir físicamente al lugar, y confirmar lo que nos piden. No es fácil.

LA NACION